MVSep Woodwind — это высококачественная модель для разделения музыки на деревянные духовые инструменты и всё остальное. Список инструментов: гобой, саксофон, флейта, фагот, кларнет, флейта-пикколо, английский рожок, прочие деревянные духовые.

MVSep Woodwind — это высококачественная модель для разделения музыки на деревянные духовые инструменты и всё остальное. Список инструментов: гобой, саксофон, флейта, фагот, кларнет, флейта-пикколо, английский рожок, прочие деревянные духовые.

Волынка (Bagpipes) - это традиционный духовой музыкальный инструмент, известный своим характерным пронзительным и непрерывным звучанием.

Как она устроена:

Мешок (резервуар): Обычно изготавливается из кожи животных или современных синтетических материалов. Он служит для запаса воздуха.

Трубка для вдувания: Через неё музыкант ртом наполняет мешок воздухом (в некоторых разновидностях вместо этого используются небольшие меха, которые качают локтем).

Мелодическая трубка (чантер): Трубка с игровыми отверстиями, на которой музыкант перебирает пальцами, исполняя основную мелодию.

Бурдонные трубки (дроны): Одна или несколько трубок, которые издают постоянный, тягучий фоновый аккорд на одной ноте.

Главная особенность: Принцип игры заключается в том, что музыкант надувает мешок, а затем давит на него рукой, равномерно выталкивая воздух в звуковые трубки. Благодаря этому резервуару музыка не прерывается, даже когда исполнитель делает вдох.

Хотя волынка чаще всего ассоциируется с Шотландией (Great Highland Bagpipe) и кельтской культурой, её различные исторические вариации существуют по всей Европе, в Северной Африке и на Ближнем Востоке.

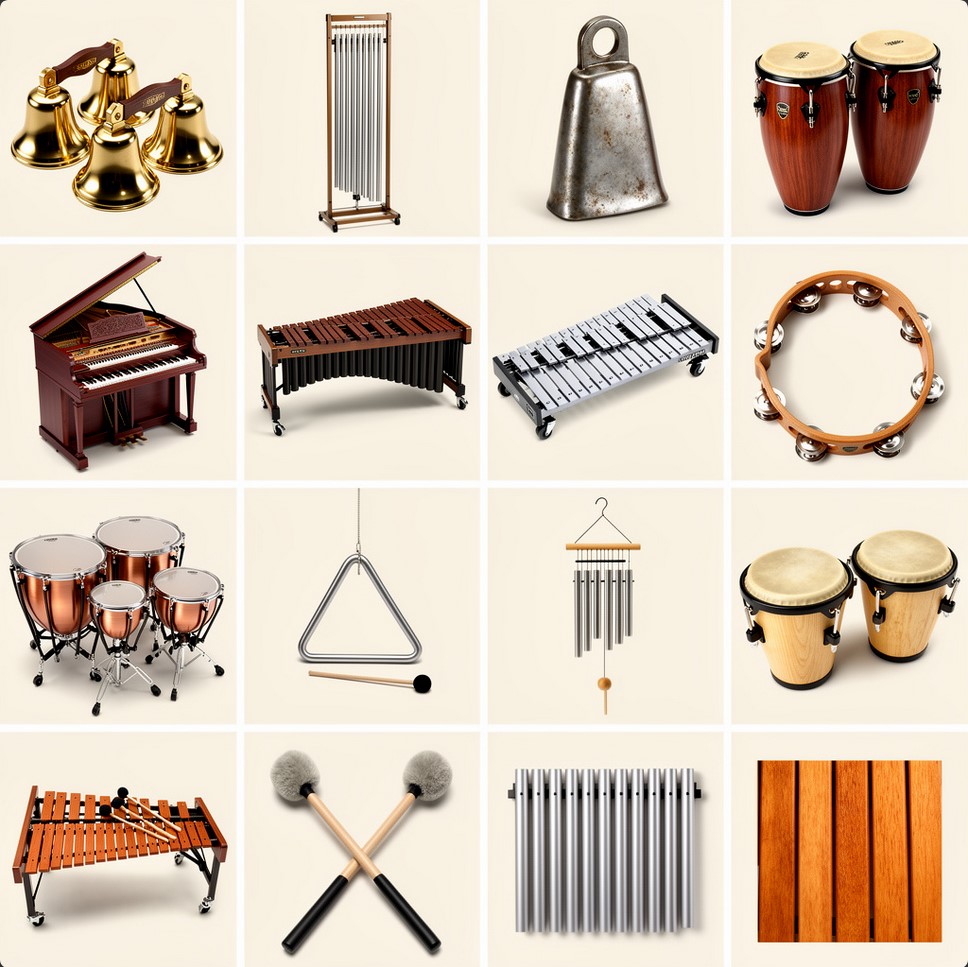

MVSep Percussion — это высококачественная модель для разделения музыки на перкуссию и всё остальное. Список инструментов: колокольчики, трубчатые колокола, коубелл, конги, челеста, маримба, глокеншпиль, бубен, литавры, треугольник, чаймс, бонги, хлопок, ксилофон, колотушки, металлические пластины, деревянные пластины.

Модель BandIt Plus для разделения треков на голос, музыку и эффекты. Она может быть полезна для телевизионных или кинематографических роликов. Модель была выложена авторами статьи "A Generalized Bandsplit Neural Network for Cinematic Audio Source Separation" в репозитории на GitHub. Модель была натренирована на наборе данных Divide and Remaster (DnR). И на данный момент имеет лучшие метрики качества среди подобных моделей.

Таблица качества

| Название алгоритма | DnR dataset |

||

| SDR Speech | SDR Music | SDR Effects | |

| BandIt Plus | 15.62 | 9.21 | 9.69 |

MVSep DnR v3 - это кинематографическая модель для разделения треков на 3 части: музыка, эффекты и диалоги. Она обучена на огромном мультиязыковом датасете DnR v3 и генерирует стемы speech, music и sfx. Метрики качества на проверочных данных получились лучше, чем у аналогичной мультиязыковой модели Bandit v2. Модель доступна в 3 вариантах: на базе архитектур SCNet, MelBand Roformer, а также ансамбль этих двух моделей. См. таблицу ниже:

| Название алгоритма |

Метрики качества в таблице лидеров DnR v3 |

||||

| music (SDR) | sfx (SDR) | speech (SDR) | |||

| SCNet Large | 9.94 | 11.35 | 12.59 | ||

| Mel Band Roformer | 9.45 | 11.24 | 12.27 | ||

| Ensemble (Mel + SCNet) | 10.15 | 11.67 | 12.81 | ||

| Bandit v2 (для сравнения) | 9.06 | 10.82 | 12.29 | ||

Braam (Браам) - это мощный кинематографический звуковой эффект (виртуальный инструмент), ставший абсолютным стандартом в современной музыке для кино и трейлеров.

Главные особенности:

Звучание: Это массивный, низкочастотный, раскатистый и часто агрессивный звук. Он напоминает апокалиптический гудок огромного корабля, тяжелый металлический скрежет или сигнал тревоги.

Происхождение: Этот звук приобрел массовую популярность после выхода фильма «Начало» (Inception, 2010) с музыкой Ханса Циммера, из-за чего его часто называют Inception Horn (гудок из «Начала»).

Как создается: Как правило, это результат сложного саунд-дизайна. Базой служат мощные низкие медные духовые (тромбоны, тубы, валторны). Затем их наслаивают на тяжелые синтезаторные басы и сильно обрабатывают эффектами: перегрузом (дисторшн), сатурацией и глубокой реверберацией.

Сегодня Braam существует в виде готовых сэмплов и библиотек для виртуальных синтезаторов (VST-плагинов), которые композиторы используют, чтобы мгновенно придать треку масштабность, напряжение или эпичность.

Алгоритм восстанавливает качество звука. Модель была предложена в этой статье и опубликована на github.

Доступны 3 модели:

1) MP3 Enhancer (автор JusperLee) - восстанавливает файлы MP3, сжатые с битрейтом 32 кбит/с до 128 кбит/с. Он не будет работать для файлов с большим битрейтом.

2) Universal Super Resolution (автор Lew) - восстанавливает более высокие частоты для любой музыки

3) Vocals Super Resolution (автор Lew) - восстанавливает более высокие частоты и общее качество для любого вокала

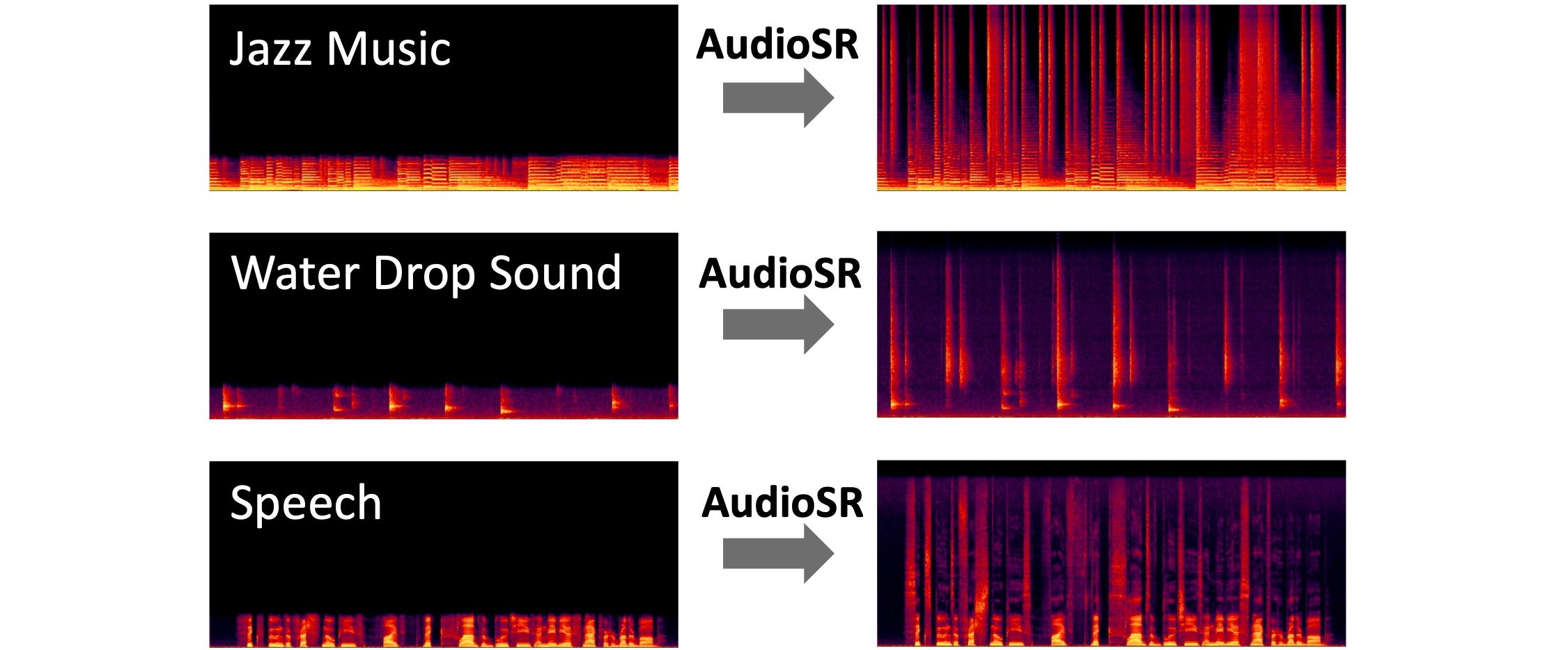

Алгоритм AudioSR: Универсальное масштабируемое аудио супер-разрешение. Алгоритм восстанавливает высокие частоты. Он работает со всеми типами аудио (например, музыка, речь, лай собаки, звук дождя и т.д.). Изначально он был обучен на монофоническом аудио, поэтому может давать нестабильные результаты на стерео.

Метрика на Super Resolution Checker for Music Leaderboard (Restored): 25.3195

Статья авторов: https://arxiv.org/pdf/2309.07314

Оригинальный репозиторий: https://github.com/haoheliu/versatile_audio_super_resolution

Оригинальный скрипт для вывода, подготовленный @jarredou: https://github.com/jarredou/AudioSR-Colab-Fork

FlashSR — алгоритм супер-разрешения аудио для восстановления высоких частот. Основан на статье FlashSR: One-step Versatile Audio Super-resolution via Diffusion Distillation.

Метрика на Super Resolution Checker for Music Leaderboard (Restored): 22.1397

Оригинальный репозиторий: https://github.com/jakeoneijk/FlashSR_Inference

Скрипт для инференса от @jarredou: https://github.com/jarredou/FlashSR-Colab-Inference

Генерация аудио по заданному текстовому запросу. Для генерации используется модель Stable Audio Open 1.0. Аудио генерируется в формате Стерео с частотой дискретизации 44.1 kHz длинной до 47 секунд. Качество довольно высокое. Запросы лучше делать на английском языке.

Примеры запросов:

1) Генерация отдельных звуков: cats meow, lion roar, dog bark

2) Генерация отдельных семплов: 128 BPM tech house drum loop

3) Генерация конкретных инструментов: A Coltrane-style jazz solo: fast, chaotic passages (200 BPM), with piercing saxophone screams and sharp dynamic changes

Whisper — это модель нейронной сети автоматического распознавания речи (ASR) и перевода речи от компании OpenAI. Модель имеет несколько версий. На MVSep мы используем самую большуюю и точную: «Whisper large-v3». Модель Whisper large-v3 была обучена на нескольких миллионах часов аудио. Это многоязычная модель, и она автоматически умеет определять язык текста. Чтобы применить модель к вашему аудио, у вас есть 2 варианта:

1) «Apply to original file» — это означает, что модель шепота будет применена непосредственно к отправленному вами файлу.

2) «Extract vocals first» — в этом случае перед использованием шепота сначала применяется модель BS Roformer для извлечения вокала. Она может удалить ненужный шум, чтобы улучшить качество работы Whisper.

У исходной модели были некоторые проблемы с таймингами транскрипции. Это было исправлено @linto-ai. Его вариант транскрипции доступен c опцией "New timestamps by linto-ai", но иногда этот метод может давать нежелательные артифакты. Оригинальный вариант таймингов доступен по опции "Old version of timestamps by whisper".

Более подробную информацию о модели можно найти здесь: https://huggingface.co/openai/whisper-large-v3 и здесь: https://github.com/openai/whisper

Parakeet — это семейство передовых моделей автоматического распознавания речи (ASR), разработанных NVIDIA совместно с Suno.ai. Эти модели построены на архитектуре Fast Conformer, созданной для обеспечения баланса между высокой точностью транскрипции и исключительной скоростью инференса. Они широко известны тем, что превосходят гораздо более крупные модели (такие как Whisper от OpenAI) по эффективности, сохраняя при этом конкурентоспособные или лучшие показатели ошибок слов (WER). Метрика качества WER: 6.03 в рейтинге Huggingface Open ASR.

MVSep предоставляет две версии модели (v2 и v3):

Страница модели v2: https://huggingface.co/nvidia/parakeet-tdt-0.6b-v2

Страница модели v3: https://huggingface.co/nvidia/parakeet-tdt-0.6b-v3

Выпущенная как высокоэффективная модель, ориентированная на английский язык, v2 утвердила Parakeet в качестве лидера по соотношению скорости и точности.

Выпуск v3 ознаменовал расширение эффективной архитектуры Parakeet с исключительно английского языка на многоязычную область без увеличения размера модели.

VibeVoice — это модель для генерации естественных разговорных диалогов из текста с возможностью использовать эталонный голос с целью его клонирования.

Нам нужно фонетическое разнообразие (все звуки языка) и живая интонация. Текст длиной около 35–40 слов при спокойном чтении как раз займет ~15 секунд.

Вот три варианта на английском под разные задачи:

Лучший выбор для общего использования. Содержит сложные звукосочетания для настройки четкости.

"To create a perfect voice clone, the AI needs to hear a full range of phonetic sounds. I am speaking clearly, taking small pauses, and asking: can you hear every detail? This short sample captures the unique texture and tone of my voice."

Для озвучки роликов, YouTube или блогов. Читайте живо, с улыбкой, меняя высоту голоса.

"Hey! I’m recording this clip to test how well the new technology works. The secret is to relax and speak exactly like I would to a friend. Do you think the AI can really copy my style and energy in just fifteen seconds?"

Для презентаций, аудиокниг или официальных сообщений. Читайте уверенно, немного медленнее, выделяя окончания слов.

"Voice synthesis technology is rapidly changing how we communicate in the digital age. It is essential to speak with confidence and precision to ensure high-quality output. This brief recording provides all the necessary data for a professional and accurate digital clone."

Pronunciation (Произношение): Старайтесь четко проговаривать окончания слов (особенно t, d, s, ing). Модели "любят" четкую артикуляцию.

Flow (Поток): Не читайте как робот. В английском важна мелодика (voice melody) — голос должен немного "плавать" вверх и вниз, а не звучать на одной ноте.

Breathing (Дыхание): Если вы делаете паузу на запятой или точке, не бойтесь сделать слышный вдох. Это добавит реализма клону.

VibeVoice (TTS) — это модель для генерации естественных разговорных диалогов из текста с возможностью создавать диалоги до 4 собеседников и длительностью до 90 минут.

Текст должен быть на английском или китайском языке, для других языков качество не гарантируется. Максимальная длина текста 5000 символов. Избегайте специальных символов. Текст должен быть оформлен в специальном формате с указанием говорящих:

Speaker 1: Hello! How are you today?

Speaker 2: I'm doing great, thanks for asking!

Speaker 1: That's wonderful to hear.

Speaker 3: Hey everyone, sorry I'm late!

Hello! How are you today?

I'm doing great!Важно:

Speaker N: (где N — номер от 1 до 4)Speaker 1: = speaker 1: = SPEAKER 1Если вам нужен монолог, то спикера можно не указывать.

Монолог (1 говорящий):

Speaker 1: Today I want to talk about artificial intelligence.

Speaker 1: It's changing our world in incredible ways.

Speaker 1: From healthcare to entertainment, AI is everywhere.Диалог (2 говорящих):

Speaker 1: Have you tried the new restaurant downtown?

Speaker 2: Not yet, but I've heard great things about it!

Speaker 1: We should go there this weekend.

Speaker 2: That sounds like a perfect plan!Групповая беседа (3-4 говорящих):

Speaker 1: Welcome to our podcast, everyone!

Speaker 2: Thanks for having us!

Speaker 3: It's great to be here.

Speaker 4: I'm excited to share our thoughts today.

Speaker 1: Let's start with introductions.Bark — это созданная компанией Suno модель на базе архитектуры трансформеров, которая представляет собой не просто традиционный инструмент синтеза речи, а полноценную генеративную систему класса «текст в аудио». Её возможности выходят далеко за рамки обычного озвучивания: помимо создания высокореалистичной речи на множестве языков, Bark умеет генерировать музыку, фоновые шумы и простые звуковые эффекты. Уникальной особенностью модели является способность воспроизводить тонкие невербальные коммуникации, такие как смех, вздохи и плач, что делает итоговое звучание максимально живым и естественным.

Стремясь поддержать сообщество, разработчики открыли доступ к предварительно обученным контрольным точкам, которые готовы к работе и разрешены даже для коммерческого использования. Тем не менее важно учитывать, что Bark создавался в первую очередь для исследовательских задач. Будучи полностью генеративной моделью, она может вести себя непредсказуемо и иногда отклоняться от введенных текстовых подсказок.

Официальный репоизторий модели: https://github.com/suno-ai/bark

В отличие от классических TTS-систем, Bark не использует SSML-разметку. Вместо этого он обучен распознавать определенные текстовые вставки (теги) как инструкции для генерации звуков.

Все управляющие команды пишутся в квадратных скобках. Важно: Сами теги должны быть написаны на английском языке, даже если основной текст, который вы генерируете, на русском, испанском или любом другом языке.

Синтаксис:

Текст до эффекта [тег_эффекта] текст после эффекта.

Bark официально распознает следующий набор токенов для невербальных звуков:

| Тег | Описание | Пример использования |

[laughter] |

Громкий, явный смех | Привет! [laughter] Как же это было смешно. |

[laughs] |

Короткий смешок, хихиканье | Ну да, конечно [laughs]. |

[sighs] |

Тяжелый вздох (усталость, облегчение) | [sighs] Я так устал от этой работы. |

[music] |

Вставка инструментальной музыки | [music] (играет фоновая музыка) |

[gasps] |

Резкий вдох (испуг, удивление) | [gasps] Я не ожидал тебя здесь увидеть! |

[clears throat] |

Откашливание (привлечение внимания) | [clears throat] Господа, прошу внимания. |

Примечание: Также существуют вариации [man laughs] и [woman laughs], но они работают стабильнее всего, если пол спикера (Speaker History) совпадает с тегом.

Чтобы заставить модель «пропеть» текст, а не прочитать его, используются музыкальные ноты.

Метод: Оберните текст в символы музыкальных нот ♪ (Shift + Alt + V на Mac или Alt+13 на Win, или просто скопируйте).

Пример: ♪ In the jungle, the mighty jungle, the lion sleeps tonight ♪

Совет: Это работает лучше всего, если вы используете английский язык, так как обучающий датасет содержал много английских песен, но на русском тоже можно добиться результата.

Хотя специальных тегов для пауз (типа

Двоеточие и тире (..., —): Используйте многоточие или длинное тире для создания пауз, колебаний или заминок в речи.

Пример: Я... я не уверен, что это правильно.

CAPS LOCK: Иногда (не гарантированно) написание слова ЗАГЛАВНЫМИ БУКВАМИ может добавить ударение или повысить громкость.

Вероятностная природа: Bark — это GPT для аудио. Если вы напишете [laughter], модель с высокой вероятностью сгенерирует смех, но иногда она может проигнорировать тег или сгенерировать странный звук.

Контекст имеет значение: Тег [laughter] сработает естественнее после шутки, чем посреди трагического предложения. Модель «понимает» семантику текста.

Шепот (Whispering): Официального тега [whisper] нет. Однако сообщество заметило, что добавление слов типа "quietly" или использование специфических спикеров (Speaker Prompts) иногда помогает, но это метод проб и ошибок.

Ограничения на сайте: в данный момент все отправленные тексты обрезаются до 1000 символов.

MVSep MultiSpeaker (MDX23C) — данная модель пытается изолировать самый громкий голос от всех остальных голосов. Модель основана на архитектуре MDX23C. Все еще в разработке.

Алгоритм добавляет к вокалу эффект «шепота». Модель создана SUC-DriverOld. Подробнее здесь.

Модель Aspiration отделяет:

Слышимое дыхание

Шипение и жужжание фрикативных согласных (например, «с» и «ф»)

Взрывные согласные: глухой взрывной звук, возникающий при произнесении согласных (таких как "п", "т", "к").

Matchering — это новый инструмент для сопоставления и мастеринга аудио. Он основан на простой идее: вы берете ДВА аудиофайла и загружаете их в Matchering:

Алгоритм сопоставляет оба этих трека и предоставляет вам обработанный трек TARGET с теми же значениями RMS, частотной характеристики, пиковой амплитуды и ширины стереобазы, что и у трека REFERENCE.

Основано на коде @sergree.

SOME (Singing-Oriented MIDI Extractor) — это инструмент для извлечения MIDI, способный конвертировать пение в MIDI-последовательность. Модель была обучена исключительно на китайском вокале, поэтому с другими языками она может работать некорректно.

Оригинальная страница: https://github.com/openvpi/SOME

Transkun — это современная open-source модель для автоматической транскрипции фортепианной музыки (Audio-to-MIDI). Официальная страничка модели: здесь. Она считается одной из лучших (SOTA — State of the Art) в своем классе. Модель умеет распознавать не только сами ноты, но и их длительность, громкость (velocity) и использование педали. В отличие от многих старых моделей, которые анализируют музыку «покадрово» (frame-based), Transkun использует подход Neural Semi-CRF (semi-Markov Conditional Random Field). Вместо того чтобы спрашивать «звучит ли нота в эту миллисекунду?», модель рассматривает события как цельные интервалы (от начала до конца ноты). В последних версиях используется Transformer (Non-Hierarchical Transformer), который вычисляет вероятность того, что определенный отрезок времени является нотой. Декодинг: Используется алгоритм Витерби (Viterbi) для поиска наиболее вероятной последовательности непересекающихся интервалов. Модель показывает отличные результаты на датасете MAESTRO (стандарт индустрии).

Basic Pitch — это современная нейросеть от исследовательской лаборатории Spotify (Audio Intelligence Lab), которая переводит любые мелодические аудиозаписи в ноты (формат MIDI). В отличие от устаревших конвертеров, эта модель умеет «слышать» не только отдельные ноты, но и аккорды, а также тончайшие нюансы исполнения. Официальная страница модели: https://github.com/spotify/basic-pitch

Basic Pitch — это «инструментально-агностическая» модель. Это значит, что она одинаково хорошо справляется с разными тембрами:

- Вокал: Напойте мелодию в микрофон, и нейросеть превратит ваш голос в партию для синтезатора.

- Струнные: Акустическая и электрогитара, скрипка, виолончель.

- Клавишные: Фортепиано, рояль, органы и синтезаторы.

- Духовые: Флейта, саксофон, труба и другие.

Важно: Модель предназначена для мелодических инструментов. Она не подходит для распознавания ударных (барабанов и перкуссии), так как фокусируется на высоте тона, а не на ритмическом шуме.

Экспериментальная модель VitLarge23 на базе Vision Transformers. По метрикам немного уступает MDX23C, но может сработать лучше в некоторых случаях.

Таблица качества

| Algorithm name | Multisong dataset | Synth dataset | MDX23 Leaderboard |

||

| SDR Vocals | SDR Instrumental | SDR Vocals | SDR Instrumental | SDR Vocals | |

| Vit Large 23 (512px) v1 | 9.78 | 16.09 | 12.33 | 12.03 | 10.47 |

| Vit Large 23 (512px) v2 | 9.90 | 16.20 | 12.38 | 12.08 | --- |

Mel Band Roformer - модель предложенная сотрудниками компании ByteDance для конкурса Sound Demixing Challenge 2023, где они заняли первое место на LeaderBoard C. К сожалению, модель не была выложена в открытый доступ и была воспроизведена по научной статье разработчиком @lucidrains на площадке github. Вокальная модель была обучена с нуля на нашем внутреннем датасете. К сожалению, нам пока не удалось достичь аналогичных метрик как у авторов.

Таблица качества

| Algorithm name | Multisong dataset | Synth dataset | MDX23 Leaderboard |

||

| SDR Vocals | SDR Instrumental | SDR Vocals | SDR Instrumental | SDR Vocals | |

| Mel Band Roformer v1 (vocals) | 9.07 | --- | 11.76 | --- | --- |

Модель LarsNet производит разделение дорожки барабанов на 5 типов: 'kick', 'snare', 'cymbals', 'toms', 'hihat'. Используется модель из репозитория на github и обученная на датасете StemGMD. Модель имеет два режима работы. В первом (по умолчанию) сначала к треку применяется модель Demucs4 HT, которая извлекает из трека только барабанную часть. Далее уже применяется модель LarsNet. Если ваш трек состоит только из барабанов, то имеет смысл использовать второй режим, где модель LarsNet применяется непосредственно к загруженному аудио. К сожалению, субъективно качество разделения уступает по качеству модели DrumSep.